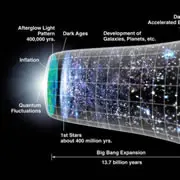

之前强化学习理论给予了神经科学以灵感和启发: 最近在理解奖励驱动学习所涉及的机制方面取得了令人振奋的进展。这一进展部分是通过输入强化学习领域(RL)的思想来实现的。最重要的是...

-

解读一PREFRONTAL CORTEX AS A META-REINFORCEMENT LEARNING SYSTEM

-

revelation of MONet

MONet: Unsupervised Scene Decomposition and Representation 1 .总的来说,这边论文讲了如上图的事情,与传统VAE不...

-

解读Been There, Done That: Meta-Learning with Episodic Recall

最近在研究的线路就是:metal learning + episodic memory. 我觉得agent 需要能学习各种任务,也需要有记忆把学到的抽象的东西保存下来,这样可...

-

解读二PREFRONTAL CORTEX AS A META-REINFORCEMENT LEARNING SYSTEM

关于多巴胺和前额皮质的故事: 观察人的大脑,有两个重要部分: 1. 基底神经节(或蜥蜴脑),其中包含VTA和黑质,其中产生多巴胺。 这一块会被激活,在得到的奖励比预估的更多...

-

详解PLANET代码(tensorflow)如何加入SAC功能

先说为什么要加? SAC 算法本质是经过熵强化的回报值最大化算法。在我们单独跑的其他实验中,包括SAC + RNN表现出很好的性能,1.replay buffer使它的采样效...

-

PLANET+SAC代码实现与解读

代码已经在正常跑实验了。以下描述的是,经过我几次尝试后改动最小的那个方案: 为planet增加SAC功能,之前写了详细思路请先参考: 详解PLANET代码(tensorflo...

-

代码解析《Learning Latent Dynamics for Planning from Pixels》

我们以数据流向为主线索,讲讲论文代码做了些什么事情。 跑算法就是先收集数据,然后把它feed到构建好的模型中去训练。这个代码还多了一步planning。planning完收到...

-

如果你是程序员,或者有一颗喜欢写程序的心,喜欢分享技术干货、项目经验、程序员日常囧事等等,欢迎投稿《程序员》专题。 专题主编:小彤花园 http://www.jianshu.com/users/4a4eb4feee62/ 【程序员】专题拒稿指北:http://www.jianshu.com/p/7c8b33b5f63b 投稿须知: 1.收录相关技术文章,但不限于技术,也可以是项目经验类的文章和程序员日常。 2.文章內不得有任何推广信息。包括但不限于公众号、微博、微信,更不得在通过投稿后再修改文章加入推广信息。你可以将这些推广以及个人信息放在个人主页介绍里。 3.字数极少,段落混乱,大段代码没有放到代码框的文章不收录 4.不相关的内容不收录,请确认文章内容和本专题相关 目前针对优质作者及爱好者,开设了官方程序员微信群,希望加入请发简信给主编小彤花园索取个人微信,主编会将你加入到【程序员】微信群,分享内容,收获知识。添加微信时备注昵称。

-

故事专题,不论是旅行生活中亲身经历的真实故事,还是童话玄幻遐想的虚构故事,这里记录你的每个故事。 欢迎向我们投稿你的故事! 所投稿件必须是一个完整的故事,故事包括但不限于:小说、世间故事、叙事散文、以叙事为主的回忆录…… 投稿前,请阅读最有趣的投稿指南: http://www.jianshu.com/p/9da8500a57f0 投稿须知: 1.建议题材:有情节的小说、身边的故事、叙事游记、以叙事为主的回忆录、职业故事等。 2.不建议题材:连载、只有大道理的鸡汤、成功学、工具文、诗歌、观点时评类文章等。 3.文章在一千字以上,排版合理,不影响阅读体验。 4.禁止外链宣传。不得有个人微信、微信公众号、微博、豆瓣链接。 专题主编:似舞 https://www.jianshu.com/u/021585ebd561 目前【故事】专题已建有专题社群,私信主编暗号“我爱故事”,即可获得入群链接。任何投稿疑惑,写作问题,感情困难,都可以进群进行申诉,会有专人解决你的问题。

-